D2HNet: Joint Denoising and Deblurring with Hierarchical Network for Robust Night Image Restoration

paper : https:// arxiv.org/abs/2207.0329 4

code: https:// github.com/zhaoyuzhi/D2 HNet

Abstract

使用现代智能手机相机进行夜间成像很麻烦,因为成像系统的见光度低,而且不可避免的噪声.在光线不足的情况下, 直接调整曝光时间和感光度不能同时获得清晰和无噪声的图像 (长曝光的图像容易导致图像模糊,短曝光图像容易引入噪点。)

虽然已经提出了许多方法来增强噪声或模糊的夜间图像,但它们在真实的夜间照片上的性能仍然不令人满意,主要有两个原因:

- 单张图像的信息十分有限。

- 合成训练图像和真实照片之间的域差距(例如,模糊区域和分辨率的差异)。

为了利用连续长曝光和短曝光图像的信息,本文提出了一种基于学习的方法来融合它们。开发了一种 D2HNet 框架, 在短曝光图像的引导下,对长曝光图像进行去模糊和增强,恢复出高质量的图像 。为了缩小两个域的差距,本文利用了两阶段 DeblurNet-EnhanceNet 架构,该架构在固定的低分辨率上执行精确的模糊去除,以便它能够处理不同分辨率输入中的大范围模糊。此外,本文还从高清视频中合成了一个 D2-Dataset 并在其上进行实验。验证集和真实照片上的结果表明,本文的方法取得了更好的视觉质量和最先进的定量分数。

Introduction

由于传感器和光学系统的限制,在夜间用现代智能手机拍摄高质量的照片非常困难。这是计算摄影领域长期存在的现实问题。在夜间条件下,用智能手机有效地获取清晰、干净的照片需求量很大。主要难点在于成像过程中图像信号相对于固有噪声太弱,产生较低的信噪比,降低了图像质量。为了获得更高的信噪比,有很多解决方案,要么在硬件层面(相机内解决方案),要么在算法层面,通常属于下列三种类型之一:

- 物理解决方案 :使用更大的传感器,打开光圈,使用闪光灯,或设置更长的曝光时间;

- 单图像复原 :对长曝光图像进行运动模糊去模糊处理,或对噪声严重的短曝光图像去噪处理

- 连续图像恢复 :将快速连续拍摄的图像信息结合起来。

这些解决方案虽然提高了夜间图像的恢复质量,但可能 无法满足移动摄影对效果和效率的双重要求 。此外,训练图像和真实图像之间的数据分布差距(如模糊区域、分辨率的差异)仍也是一个关键问题。

Data Acquisition

本文提出了 D2-Dataset数据集用于训练和基准测试。 数据生成的流程如下:

- 作者从网上收集了30个分辨率为1440 x 2560 的高清视频。这些视频几乎没有噪声,且覆盖了广泛的场景。在每个视频中每10秒采样60帧连续的画面(原始60帧/秒的视频大约为1秒),以减少重复的场景,避免场景切换。

- 作者使用视频帧插值模型SuperSloMo[31]将原来的60帧/秒视频增加到960帧/秒。它可以平滑视频,模拟逼真的模糊效果。

- 通过平均插值帧,连续合成长曝光图像 l 和短曝光图像 s , 同时,作者增加了 l 和 s 之间的时间间隔来模拟硬件读写时间的限制。同时提取出相应的清晰的单帧,即长曝光图像的最后一帧 l_{last} 和短曝光图像的第一帧 s_{first} 。

测试集部分, 作者用小米Note 10智能手机拍摄了28对分辨率为3472ˆ4624的长曝光和短曝光图像。为了保证长曝光和短曝光图像的整体亮度大致相同,设置它们的“ ISO x 曝光时间 ”相等。具体来说,长曝光图像的曝光时间设定为短曝光时间的8倍,其ISO为短曝光图像的1/8 .

Methodology

Problem Formulation

l_n 和 s_n 分别表示含噪声的长曝光图像和短曝光图像。 z 表示干净的图像。

D2HNet Architecture and Optimization

在第一阶段,两个输入被下采样到一个更小的和固定的分辨率, 这样做限制了长曝光图像的运动尺度和像素位移。然后,利用具有一定DeblurNet根据短曝光图像的边缘信息,对模糊的区域进行精确的去模糊处理。

在第二阶段,为了增强下采样过程中丢失的细节,EnhanceNet对上采样后的第一阶段网络输出和长-短曝光图像输入进行原始分辨率的后处理。最终得到增强的结果。

DeblurNet

在训练和测试阶段,我们使用平均池化作为降采样算子,因为它可以更好地模拟低分辨率和高分辨率图像之间的物理差异。然后再通过双线性插值进行上采样。最后经过残差块输出的特征与降采样后的长曝光图像相加,输出去模糊后的图像。

EnhanceNet

首先介绍一下可变性卷积,可变形卷积与普通卷积的不同之处在与它的卷积核多了一个偏移量,可以学习到更大范围的特征。

上图是可变形卷积的学习过程,首先偏差是通过一个卷积层获得,该卷积层的卷积核与普通卷积核一样。输出的偏差尺寸和输入的特征图尺寸一致。生成通道维度是2N,分别对应原始输出特征和偏移特征。这两个卷积核通过双线性插值和后向传播算法同时学习。

最上面的图像是在大小不同的物体上的激活单元。

中间层是为了得到顶层激活单元所进行的采样过程,左图是标准的3x3方阵采样,右图是非标准形状的采样,但是采样的点依然是3x3。

最下面一层是为了得到中间层进行的采样区域。明显发现,可变形卷积在采样时可以更贴近物体的形状和尺寸,而标准卷积无法做到这一点。

EnhanceNet由三个模块组成:特征金字塔模块,图像对齐与特征融合模块以及图像重建模块。特征金字塔模块有两个分支,两个特征金字塔有5层,分别是 {F_s}^1 - {F_s}^5 和{F_l}^1 - {F_l}^5 。由于输入的 L_n和S_n 不是对齐的,所以需要通过对齐模块对长曝光的特征进行对齐,对齐模块主要使用 可变形卷积实现 ,他 使得下一层的结构可以更好的融合两个特征金字塔的信息 。

- 首先计算的是最下面一层(第五层)的偏移量,因为第五层的分辨率是最小的,所以他们之间不对齐的地方也比较小,学习到的偏移量相对准确。

2. 然后,将学习到的偏移量传递到上层,以学习更精确的偏移量。这个过程是通过层次细化的方式逐层完成的。

3. 在长曝光的特征 {F_l}^1-{F_l}^5 对齐以后,开始进行特征融合。即将对齐后的特征与 {F_s}^i concat,然后送给残差块处理。并传给上一级结构的末尾进行concat。

Data Processing

VarmapSelection:

是一种基于方差映射的选择方案,以解决不平衡的模糊问题,提高了D2HNet的鲁棒性。由于模拟长曝光图像 l 的大部分区域都是低模糊程度的,在训练时简单随机地选择patch会造成 损失波动 和高模糊区域去模糊能力不足。VarmapSelection方案使用方差映射来表示模糊水平,并选择模糊区域大的patch进行训练。

\left.l_{\text {varmap }}=\min (\operatorname{Var}(l)) / \operatorname{Var}\left(l_{\text {last }}\right), 1\right) l_{varmap} 的值越小表示这个区域越模糊。

为了确定随机选择的patch是否具有较大的模糊,作者选择根据训练集的方差统计来定义一个阈值,来选出模糊程度较大的图像补充到训练集中。

Appearance Adjustment:

为了模拟夜间图像,需要 降低整体的亮度,还需要调整颜色来模拟长曝光和短曝光图像之间的差异。调整亮度使用的是反Gama矫正,

I A(u)=\max (u, \varepsilon)^{g}, \text { for } u \in\{s, l, z\} , ε = 10 ^{-8} , g = [1/0.6, 1/0.7, 1/0.75, 1/0.8, 1/0.9]

调整颜色使用的是简单的线性变换。

C A(s)=a \cdot s+b , a = [0.3,0.6] , b = [0.001, 0.01]

Noise Modeling

首先将sRGB格式的图像转换成RAW格式,然后在上面添加各种类型的噪声,噪声模型是在小米10上校准过的。

CutNoise

为了平衡网络对长曝光图像(模糊图像)和短曝光图像(噪声图像)的学习,将短曝光图像对应的ground truth随机剪裁到噪声图像的相同位置上,剪裁的形状为方形。有了CutNoise, D2HNet不会退化到只学习较模糊的长曝光,而是被迫学习融合较清晰的短曝光输入的信息,因此能够产生较清晰的输出。

Experiment

Long-short Fusion Method Experiments

所有对比的方法都被修改成接收两个图像的输入,同时还增加了三个双阶段的网络,分别命名为:

- TP1: image denoising by SGN + long-short fusion by SGN;

- TP2: image deblurring by DeblurGAN + long-short fusion by SGN;

- TP3: long-short fusion by SGN + long-short fusion refinement by SGN;

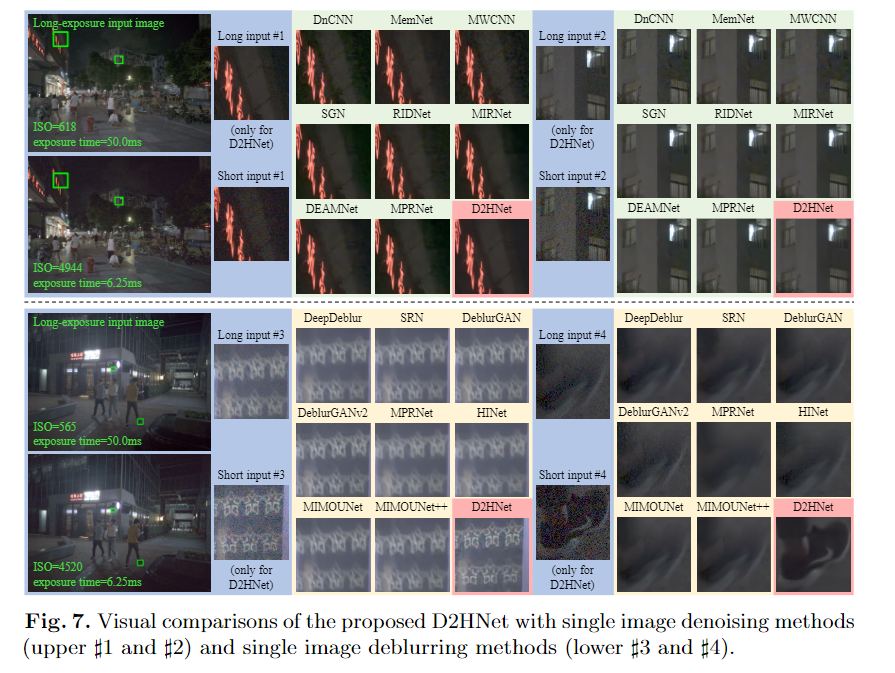

Single-image Denoising and Deblurring Method Experiments

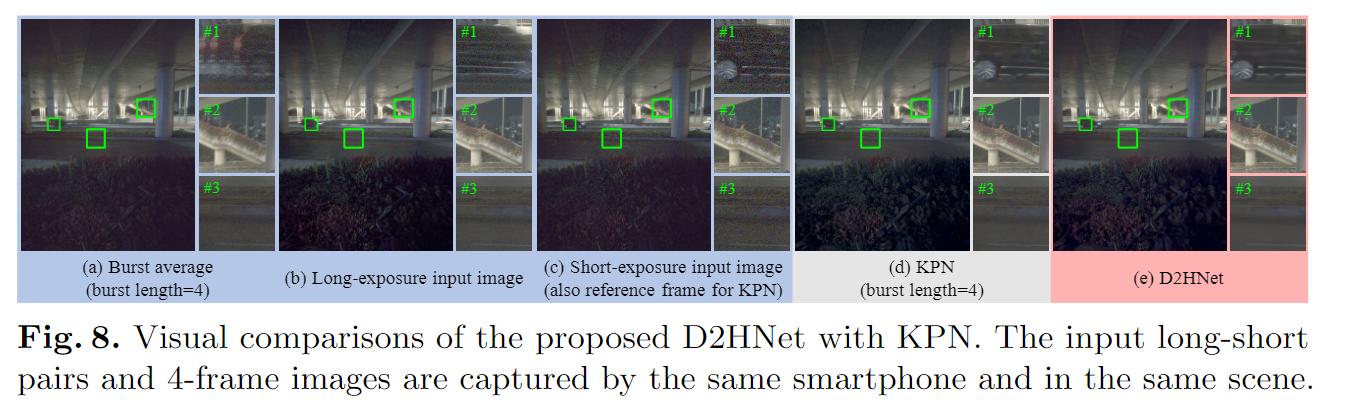

Burst-image Method Experiments

Ablation Study