```bash

pip install rpg_vid2e/esim_py/

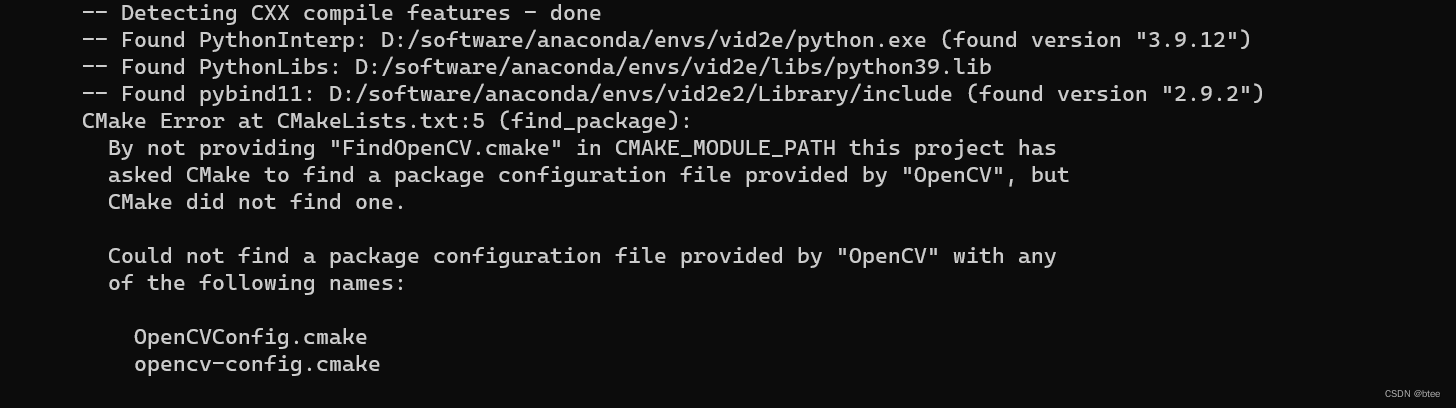

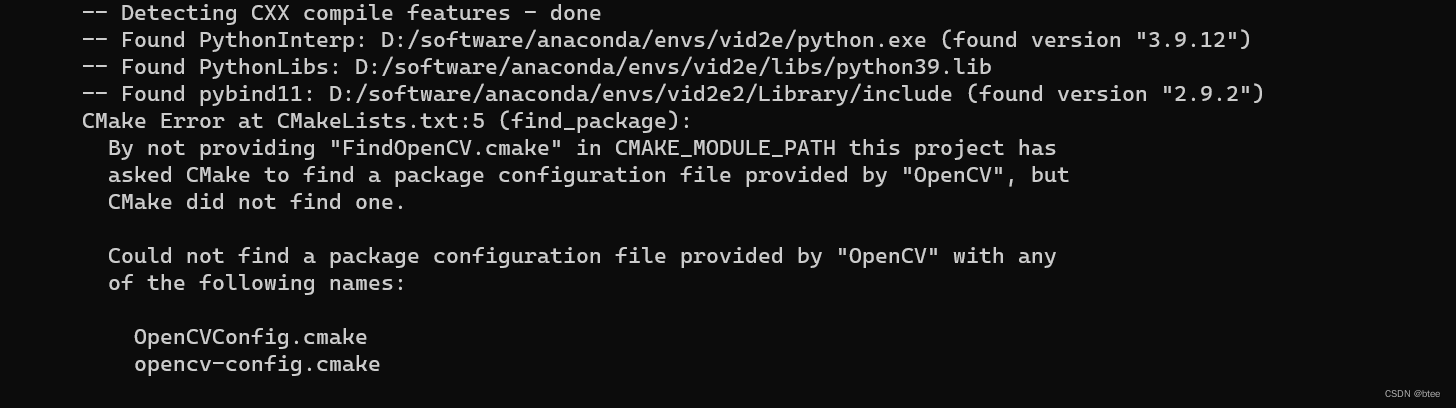

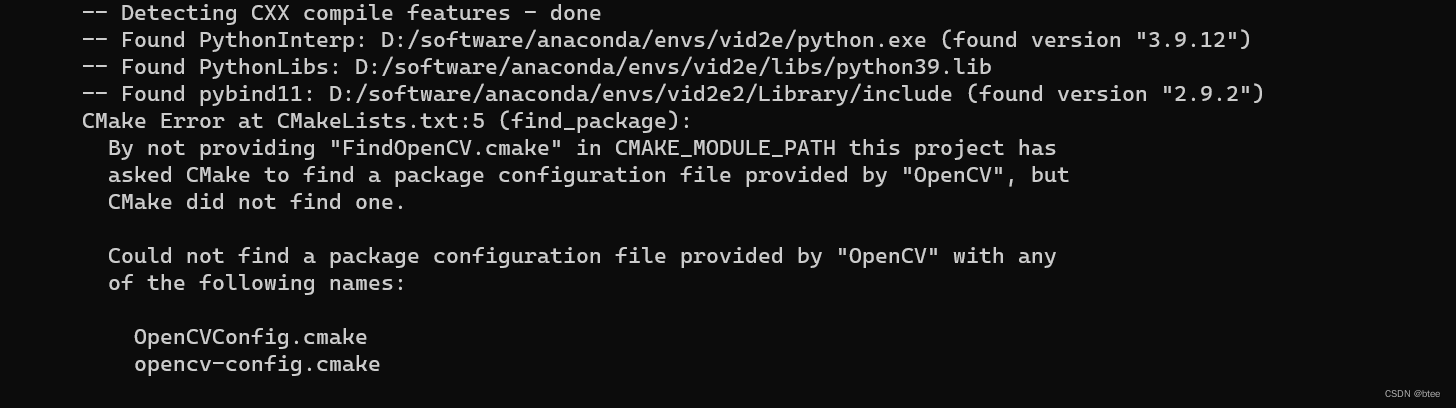

这个部分运行的时候报错OpenCVconfig.Cmake 找不到,如图:

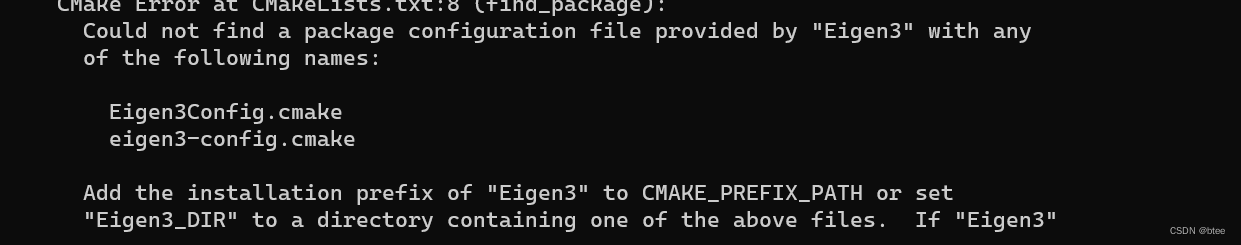

以及之后的Eigen3

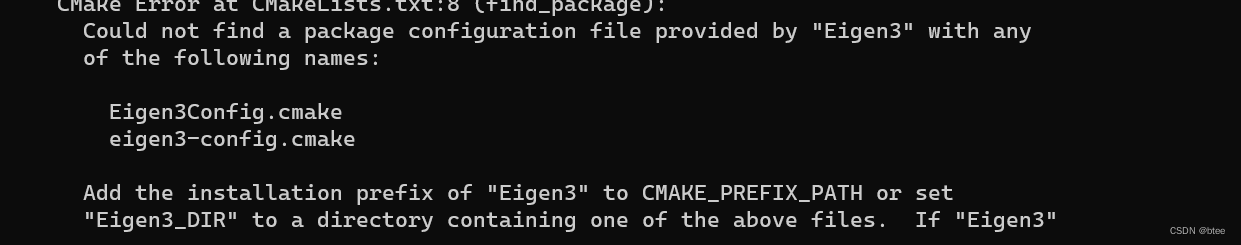

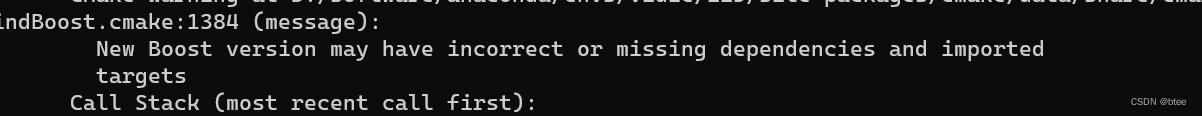

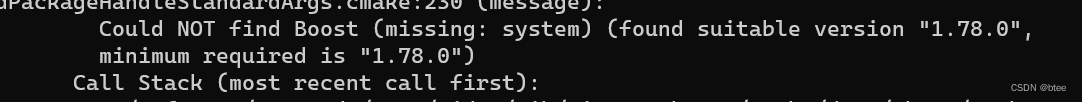

boost

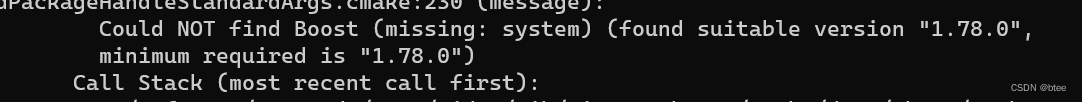

这里要先安装OpenCV,eigen和boost,安装教程有很多这里不多赘述。

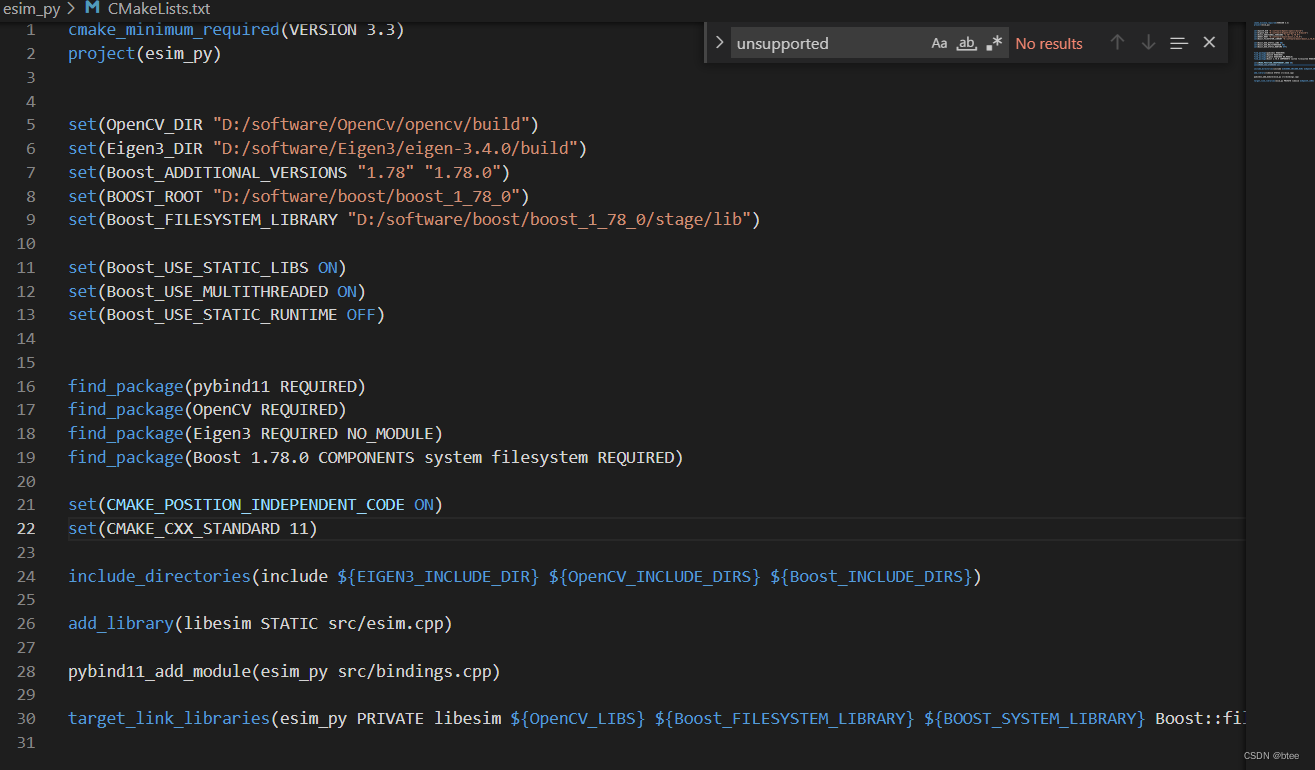

在安装完之后,要将地址写到esim_py/cmakelist.txt文件下,我的修改如下:

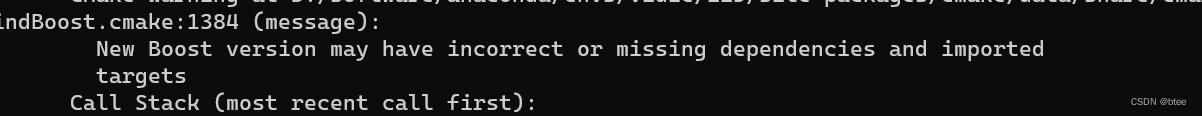

在安装boost的时候,还报出了一个版本不匹配的问题,我查了一些资料是由于CMAke版本太旧和Boost版本太新的问题,试了各种版本的boost,最后1.78.0的版本是可以的。

于是,Cmake的部分解决了。

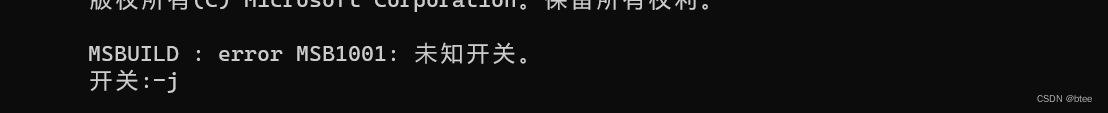

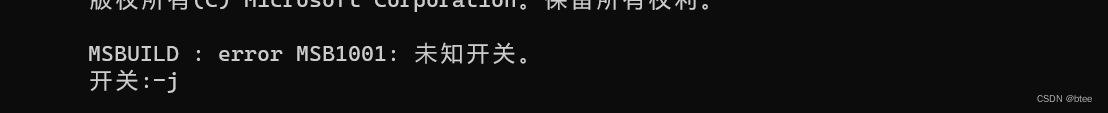

然后,接下来报错msbuild:error MsB1001出现未知开关。

这里我也不知道解决,于是我去源代码把这个地方注释掉了,于是这个问题就跳过了,玄学…

然后出现了几个找不到文件的错误:把eigen3/Eigen 和Eigen3/build/Unsupported放到eSIM_py/include文件下,问题解决~

第一部分就成功啦

论文:Video to Events: Recycling Video Datasets for Event Cameras对本地的代码调通遇到的问题如下:```bashpip install rpg_vid2e/esim_py/这个部分运行的时候报错OpenCVconfig.Cmake 找不到,如图:以及之后的Eig

视频到事件:为事件摄像机回收视频数据集

该存储库包含实现视频到事件转换的代码,如Gehrig等所述。 CVPR'20和使用的数据集。 该文件可以在找到

如果您在学术环境中使用此代码,请引用以下工作:

,Mathias Gehrig,JavierHidalgo-Carrió, ,“视频到事件:为事件摄像机回收视频数据集”,计算机视觉与模式识别(CVPR)会议,2020年

@InProceedings { Gehrig_2020_CVPR ,

author = { Daniel Gehrig and Mathias Gehrig and Javier Hidalgo-Carri\'o and Davide Scaramuzza } ,

title = { Video to Events: Recycling Video Datasets for Event Cameras }

通常为了兼容IE与FireFox,一般的事件处理方法为: 代码如下: btn.onclick=handle_btn_click; function handle_btn_click(evt){ if(evt==null)evt=window.event;//IE //处理事件. } 对于简单的程序,这不算麻烦. 但对于一些复杂的程序,某写函数根本就不是直接与事件挂钩的.如果要把event传进该参数,那么所有的方法都要把event传来传去..这简直就是噩梦. 下面介绍一个解决这个麻烦事的方法,与原理. JScript中,函数的调用是有一个 func.caller 这个属性的. 例如 代码如

今日读了论文"v2e: From Video Frames to Realistic DVS Events",讲的是从video生成event,文中详细分析了event生成过程中一些不理想的情况,指出现有的仿真方法(ESIM和VID2E)都仅考虑了噪声和对比度,缺少其他考虑。作者有Tobi Delbruck,可见越是大佬的组,研究的内容就越是基础。

事件成因简单总结,当光照时,photodiode产生电流Ip,对应的电容Cpd相当于放电,在C左侧产生电压Vp,经过放大器后Vd,与参考电压比较,生成

关于E2VID中image reconstruction folder转为rosbag的方法

附送GitHub链接:https://github.com/uzh-rpg/rpg_e2vid#image-reconstruction-folder—rosbag

图像转为rosbag

原文

代码

我们git clone 原文的

代码后,进入到rpg_e2vid中打开终端然后复制以上的

代码进去。

代码说明:

datasets 就是之前你跑原文

代码用的哪个数据包,就写哪个(我就是用的dynamic_6dof);

RPG维护的github的文章许多也没有及时补充,所以只能自己去搜。最近简单翻看了CVPR2020中,关于事件相机研究的几篇论文。在此做一下简单总结。由于涉及方向较多,许多文章不太能看懂,所以只是泛读,了解最新的研究在做什么。

本文仅用作个人总结,不保证理解的正确性。转载请注明出处。

0. 下载地址

直接从CVPR2020的Open Access中进行下载:https://openaccess.thecvf.com/CVPR2020

我上传了网盘,可以下载:

链接: https://pan.baid

C#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_EventC#例子代码 A0030_E

We present a new representation and recognition method for human activities. An activity

is considered to be composed of action threads, each thread being executed by a single actor. A

single-thread action is represented by a stochastic finite automaton of event states, which are

recognized from the characteristics of the trajectory and shape of moving blob of the actor using Bayesian methods. A multi-agent event is composed of several action threads related by temporal constraints. Multi-agent events are recognized by propagating the constraints and likelihood of event threads in a temporal logic network. We present results on real-world data and performance characterization on perturbed data.

网上百度到的大部分都是一步一步根据提示运行,我们可以根据他们的教程一步一步运行完成,参考如何创建.net core app程序https://www.cnblogs.com/jixiaosa/archive/2019/03/01/10457588.html,但是等你创建完了,纳尼???????是不是有很多的小问号。如果你的目录不是工作目录,那么你的配置文件就要手动生成。

vs code中使用模板...

在Linux中,可以使用evtest工具来调试input子系统中的event。evtest是一个简单的用户空间工具,它可以打印出来自设备的输入事件,并允许用户测试输入设备的功能。以下是使用evtest调试event的步骤:

1. 安装evtest工具。在大多数Linux发行版中,可以使用包管理器来安装evtest。

2. 打开终端,并使用以下命令列出系统中的输入设备:

$ cat /proc/bus/input/devices

3. 找到要调试的设备,并记录设备的ID号。

4. 运行evtest工具,并指定要测试的设备ID号:

$ sudo evtest /dev/input/eventX

其中,eventX是要测试的设备ID号。

5. 当evtest运行时,它将打印出所有从设备接收到的输入事件。用户可以通过按下键盘、鼠标或其他输入设备的按钮来测试设备的功能,并观察evtest的输出。

6. 当测试完成后,可以使用Ctrl+C键来停止evtest。

论文阅读 | Event Transformer. A sparse-aware solution for efficient event data processing

qq_41111304:

论文阅读 | Motion Aware Double Attention Network for Dynamic Scene Deblurring

btee:

论文阅读 | Motion Aware Double Attention Network for Dynamic Scene Deblurring

热心市民老H:

论文阅读 | Motion Aware Double Attention Network for Dynamic Scene Deblurring

btee:

论文阅读 | Motion Aware Double Attention Network for Dynamic Scene Deblurring

sweetsboy_ly: