- 输入网页链接,自动生成快照

- 标签化管理网页链接

|

|

阳刚的甜瓜 · 韩国传统婚礼10大习俗_新娘_新郎_娘家· 4 月前 · |

|

|

不羁的硬盘 · 国新办就2024中关村论坛有关情况举行发布会 ...· 4 月前 · |

|

|

乖乖的荒野 · 大智近妖文集_百度百科· 5 月前 · |

|

|

大鼻子的热带鱼 · 视频号小店保证金退款入口在哪? | 微信开放社区· 8 月前 · |

|

|

旅行中的荒野 · 崔永元, 你的商人底裤掉了· 10 月前 · |

1. Interpreting multivariate interactions in DNNs(2021 AAAI)

解决的问题:

- 衡量特征组合之间的显著性交互来解释DNN的预测

- NLP领域内shapely value计算的难度比较大

方法和创新:

- 定义和量化了DNN中多个输入变量之间的交互作用,能够同时反映变量间的正交互和负交互

- 通过对于交互组合的计算可以提取原型特征,从而能够从博弈交互的视角来解释DNN

- 通过采样方式对shapely value的值进行逼近运算

- 首先是对于 shapely value的定义 ,可以将神经网络的预测看做一个多个玩家(特征)的游戏(预测),每个玩家对于游戏结果的边际贡献可以根据公式进行计算

- 两个玩家间的交互 (将{i,j}组合看做一个玩家)

- 同理推广到 多个玩家间的交互 :

**指标T([A])**同时量化正交互和负交互

T ( [ A ] ) = B _ { \max } ( [ A ] ) - B _ { \min } ( [ A ] )=\max _ { \Omega } \sum _ { C \in \Omega } \phi ( C | N _ { C } ) - \min _ { \Omega } \sum _ { C \in \Omega } \phi ( C | N _ { C } )

T

(

[

A

]

)

=

B

max

(

[

A

]

)

−

B

min

(

[

A

]

)

=

Ω

max

C

∈

Ω

∑

ϕ

(

C

∣

N

C

)

−

Ω

min

C

∈

Ω

∑

ϕ

(

C

∣

N

C

)

解决的问题 :

- 数学及实验证明了dropout能够通过抑制DNN中的特征的交互作用来防止过拟合

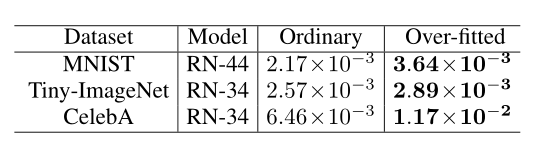

- 过拟合采样通常比其他采样样本有更大的交互作用

- 通过上述证明了dropout的作用的原因,并根据博弈论观点设计了loss来提升dropout的性能

- 分析了DNN的交互特征关系

方法和创新 :

-

定义由深度神经网络编码的交互(两个特征间)

I ( i , j ) \stackrel { \text { def } } { = } \phi ( S _ { i j } | N ^ { \prime } ) - [ \phi ( i | N \backslash \{ j \} ) + \phi ( j | N \backslash \{ i \} ) ] = \sum _ { S \subseteq N \backslash \{ i , j \} } P _ { \text { Shapley } } ( S | N \backslash \{ i , j \} ) \Delta f ( S , i , j )\\I ( i , j ) = \sum _ { s = 0 } ^ { n - 2 } [ \frac { I ^ { ( s ) } ( i , j ) } { n - 1 } ] , \quad I ^ { ( s ) } ( i , j ) \stackrel { \text { def } } { = } E _ { S \subseteq N \backslash \{ i , j \} , | S | = s } [ \Delta f ( S , i , j ) ] I ( i , j ) = def ϕ ( S i j ∣ N ′ ) − [ ϕ ( i ∣ N \ { j } ) + ϕ ( j ∣ N \ { i } ) ] = S ⊆ N \ { i , j } ∑ P Shapley ( S ∣ N \ { i , j } ) Δ f ( S , i , j ) I ( i , j ) = s = 0 ∑ n − 2 [ n − 1 I ( s ) ( i , j ) ] , I ( s ) ( i , j ) = def E S ⊆ N \ { i , j } , ∣ S ∣ = s [ Δ f ( S , i , j ) ]

其中 P _ { \text { Shapley } } ( S | N\backslash\{i,j\} ) = \frac { (n - | S | -2) ! | S | ! } { ( n-1 ) ! } P Shapley ( S ∣ N \ { i , j } ) = ( n − 1 ) ! ( n − ∣ S ∣ − 2 ) ! ∣ S ∣ ! ,通过定义进行可视化之后(将图片划分为16*16的网格,然后计算邻居网格间的相互作用,并对结果进行可视化),可以看出DNN对于对于网络的交互主要集中在人脸部分

-

dropout和交互关系的证明

考虑一个子集 I ^ { ( s ) } ( i , j ) = E _ { S \subseteq N \backslash \{ i , j \} , | S | = s } [ \sum _ { T \subseteq S } R ^ { T } ( i , j ) ] = \sum _ { 0 \leq q \leq s } \left( \begin{array} { l } { s } \ { q } \end{array} \right) J ^ { ( q ) } ( i , j ) = \sum _ { 0 \leq q \leq s } \Gamma ^ { ( q ) } ( i , j | s ) I ( s ) ( i , j ) = E S ⊆ N \ { i , j } , ∣ S ∣ = s [ T ⊆ S ∑ R T ( i , j ) ] = 0 ≤ q ≤ s ∑ ( s q ) J ( q ) ( i , j ) = 0 ≤ q ≤ s ∑ Γ ( q ) ( i , j ∣ s )

当使用dropout后,由于会随机丢掉一些特征,假设我们只考虑没有丢掉的特征 I _ { \text { dropout } } ^ { ( s ) } ( i , j ) = \underset { S \subseteq N \backslash \{ i , j \} , | S | = s } { E } [ \underset { S ^ { \prime } \subseteq S , | S ^ { \prime } | = r } { E } ( \sum _ { T \subseteq S ^ { \prime } } R ^ { T } ( i , j ) ) ] = \sum _ { 0 \leq q \leq r } \Gamma ^ { ( q ) } ( i , j | r ) I dropout ( s ) ( i , j ) = S ⊆ N \ { i , j } , ∣ S ∣ = s E [ S ′ ⊆ S , ∣ S ′ ∣ = r E ( T ⊆ S ′ ∑ R T ( i , j ) ) ] = 0 ≤ q ≤ r ∑ Γ ( q ) ( i , j ∣ r )

由此式,可得:

1 \geq \frac { \Gamma ^ { ( 1 ) } ( i , j | r ) } { \Gamma ^ { ( 1 ) } ( i , j | s ) } \geq \cdots \geq \frac { \Gamma ^ { ( r ) } ( i , j | r ) } { \Gamma ^ { ( r ) } ( i , j | s ) } \geq 0 , \quad \frac { I _ { \text { dropout } } ^ { ( s ) } ( i , j ) } { I ^ { ( s ) } ( i , j ) } = \frac { \sum _ { 0 \leq q \leq r } \Gamma ^ { ( q ) } ( i , j | r ) } { \sum _ { 0 \leq q \leq s } \Gamma ^ { ( q ) } ( i , j | s ) } \leq 1 1 ≥ Γ ( 1 ) ( i , j ∣ s ) Γ ( 1 ) ( i , j ∣ r ) ≥ ⋯ ≥ Γ ( r ) ( i , j ∣ s ) Γ ( r ) ( i , j ∣ r ) ≥ 0 , I ( s ) ( i , j ) I dropout ( s ) ( i , j ) = ∑ 0 ≤ q ≤ s Γ ( q ) ( i , j ∣ s ) ∑ 0 ≤ q ≤ r Γ ( q ) ( i , j ∣ r ) ≤ 1

右边可以看出当使用dropout后,推理模式的矢量通常会显著减少

然后文章通过实验证明了:1. 当使用dropout时拥有更多激活单元(即交互阶数越高)的推理模式更不容易被采样,因此对于dropout的影响更大 2. 使用dropout以后会明显降低交互

阶数高的交互在dropout后被显著抑制了

在使用dropout后整个图像的交互都被抑制了

阶数高的交互在dropout后被显著抑制了

在使用dropout后整个图像的交互都被抑制了

-

交互强度和过拟合之间的关系

在分类任务中,过拟合的样本通常是异常样本,过拟合样本通常比正常样本造成更强的交互作用

-

通过交互关系loss来提高dropout的表现

\text { Lossinteraction } = E _ { i , j \in N , i \neq j } [ | I ( i , j ) | ] = E _ { i , j \in N , i \neq j } [ | \sum _ { S \subseteq N \backslash \{ i , j \} } P _ { \text { Shapley } } ( S | N \backslash \{ i , j \} ) [ \Delta f ( S , i , j ) ] | ] Lossinteraction = E

-

交互强度和过拟合之间的关系