项目码云(Gitee)地址:

https://gitee.com/banmajio/RTSPtoRTMP

项目github地址:

https://github.com/banmajio/RTSPtoRTMP

个人博客:

banmajio’s blog

javacv使用ffmpeg将rtsp转rtmp直播流播放的问题解决与优化系列文章:

FFmpeg转封装rtsp到rtmp(无需转码,低资源消耗)

JavaCV中FFmpegFrameGrabber调用start()方法时出现阻塞的解决办法

JavaCV使用FFmpeg进行rtsp转rtmp直播流画面延时的优化方法

JavaCV1.5.3版本FFmpegFrameGrabber初始化的时候加载时间长的解决方法

av_write_frame() error -22 while writing video packet解决方法

场景描述

:使用之前博客中的

FFmpeg转封装rtsp到rtmp(无需转码,低资源消耗)

服务进行直播流的播放时,发现从调用api到客户端播放器出现画面会耗时3-7秒所有,也就是说播放器点击播放后,会黑屏几秒才会出现直播画面。

问题分析

:通过debug发现两个地方会影响画面加载速度:

1:由于首帧pts和dts不相等导致的画面延时

2:FFmpegFrameGrabber调用start()方法执行时间太长导致画面延时

下面从上述两个方面对画面延时问题进行解决

DTS(Decoding Time Stamp):即解码时间戳,这个时间戳的意义在于告诉播放器该在什么时候解码这一帧的数据。

PTS(Presentation Time Stamp):即显示时间戳,这个时间戳用来告诉播放器该在什么时候显示这一帧的数据。

根据ffmpeg打印的信息猜测是因为探测流信息之后,有一些探测阶段的pkt被缓存了下来。当grabber获取到pkt的时候,dts从0开始累增,但是之前的pts没有被重置,当前的dts一直都小于之前的那个pts的值,所以这些包会被丢弃掉,直到dts累增到大于等于上一包pts的时候,才会播放。

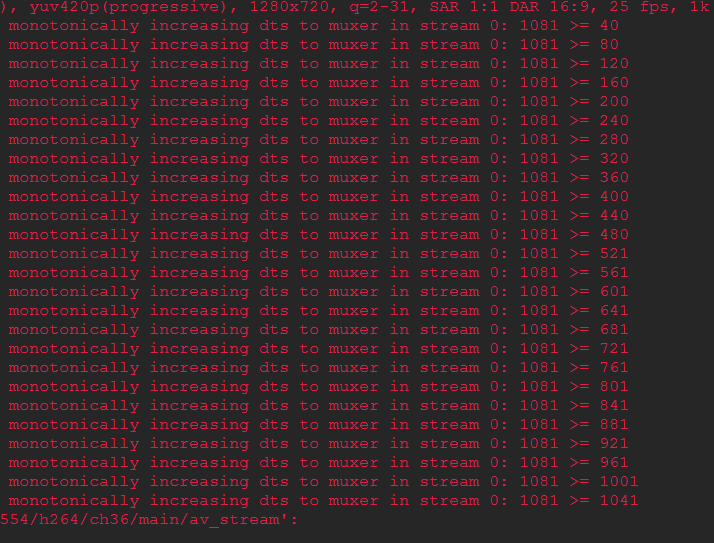

FFmpeg提示信息如下图:

可以看到首帧的pts是从1081开始的,而dts是从0开始的。所以dts会一直累加直到大于等于pts的值。

有两种方法可以解决上图中的报错信息

1.在推流函数中,获取grabber数据包之前,将缓冲释放掉

logger.info(cameraPojo.getRtsp() + " 开始推流...");

grabber.flush();

for (int no_frame_index = 0; no_frame_index < 5 || err_index < 5;) {

try {

nowThread.sleep(1);

AVPacket pkt = null;

2.直接在根源上制止这种行为的发生。在grabber.start()函数内会有一个探测流信息的函数avformat_find_stream_info(),在这边可以设置一个属性flags,在探测流信息的时候读取的数据包不放入AVFormatContext的缓冲区packet_buffer中。

oc.flags(AVFormatContext.AVFMT_FLAG_NOBUFFER);

AVDictionary optionOut = new AVDictionary(null);

if ((ret = avformat_find_stream_info(oc, (PointerPointer) null)) < 0) {

throw new Exception("avformat_find_stream_info() error " + ret + ": Could not find stream information.");

if (av_log_get_level() >= AV_LOG_INFO) {

av_dump_format(oc, 0, filename, 0);

以上两种方法都可以完美解决ffmpeg 出现Application provided invalid, non monotonically increasing dts to muxer in stream 0 错误的情况。

如上文所言,在start()函数内会有一个探测流信息的函数avformat_find_stream_info();这个函数主要是读一些包(packets ),然后从中提取出流的信息。对于这个函数更详细的解释和源码分析可以参考:ffmpeg源码分析5-avformat_find_stream_info()这篇博客。

在执行到这个函数的时候,会消耗大量的时间,甚至出现阻塞现象导致函数无法返回。

可以通过设置两个属性来限制此函数的执行时间:

1.probesize属性限制avformat_find_stream_info接口内部读取的最大数据量,probesize属性的默认值是5000000 B的数据量,一般情况下50x1024的数据量足够探测出高清摄像头一帧的信息,这个值可以通过摄像头最大码率值来设置,只要大于最大码率值即可。

2.max_analyze_duration属性设置avformat_find_stream_info这个函数的持续时长,超过这个时间不结束也会结束

在调用avformat_find_stream_info()函数之前设置这两个属性可以极大的减少此函数的执行时间。

oc.max_delay(maxDelay);

oc.probesize(Integer.parseInt(streamCode));

oc.max_analyze_duration(5 * AV_TIME_BASE);

oc.flags(AVFormatContext.AVFMT_FLAG_NOBUFFER);

AVDictionary optionOut = new AVDictionary(null);

if ((ret = avformat_find_stream_info(oc, (PointerPointer) null)) < 0) {

throw new Exception("avformat_find_stream_info() error " + ret + ": Could not find stream information.");

if (av_log_get_level() >= AV_LOG_INFO) {

av_dump_format(oc, 0, filename, 0);

如有错误或者更好的解决办法,请指正!!!

JavaCV使用FFmpeg进行rtsp转rtmp直播流画面延时的优化方法由于首帧pts和dts不相等导致的画面延时问题分析解决方法FFmpegFrameGrabber调用start()方法执行时间太长导致画面延时问题分析解决方法项目github地址:https://github.com/banmajio/RTSPtoRTMP个人博客:banmajio’s blogjavacv使用ff...

RTSPtoHTTP-FLV 使用JavaCV开发的rtsp流转http-flv流(rtmp已不推荐)并进行推流的流媒体服务

求star!!!

提问求助等优先提交issues,让其他遇到同样问题的朋友可以很方便找到解决方式,尽量避免直接加微信qq咨询。业务合作可发邮件到或添加微信qq咨询。

各大浏览器目前均已不再支持flash,故推荐使用http-flv来代替rtmp使用。

只需修改本项目controller中rtmp地址生成的地方改为生成http-flv地址即可,各流媒体服务器对于http-flv地址规则可能会有差异,根据所选流媒体服务器来制定http-flv地址。

个人博客:

csdn博客:

gitee地址:

可以实现各h264编码的监控设备rtsp流转rtmp流(只需要改动controller中rtsp指令的拼接格式)

接口调用方式:

该项目中的一些处理是为了满足公司项目需

av_dict_set(&opts, "rtsp_transport", "tcp", 0); //设置tcp or udp

av_dict_set(&opts, "stimeout", "3000000", 0); //设置超时3秒

看来不是的,这里对延迟是有处理机制.

avformat_find_stream_info(pFo

问题产生的原因

最近在捣鼓图像方面的项目,项目过程中,发现使用cv2.VideoCapture这个方法获取rtsp流会有一定的延迟,于是就有了这篇文章。方法步骤如下

1. 安装ffmepg-python包

打开终端进入你的anacondad虚拟环境或者python环境,用pip包进行安装

pip install ffmpeg-python

2. 安装ffmpeg

目前我还没找到解耦ffmpeg软件的方法,下面程序跑通必选安装此软件并将其添加到环境变量当中。

去官网(https://ffmpeg.org/)

当我们使用ffmpeg的时候,假如不使用编码,直接上传到rtmp服务器,那么视频是没什么延时的,但是这样流量却非常的大,因为假如不编码,就意味着不压缩,直接原始数据上传,是非常消耗流量的。

但假如我们需要编码呢,比如使用了h264或libx264,那么视频起码有10秒左右的延时

如下面的代码,同时采集本地麦克风、本地桌面视频,做视频直播的代码:

ffmpeg -f dshow -i audio=\"麦克风阵列 (Realtek(R) Audio)\" -acodec aac -f gdigra..

FFMPEG关于推流端降低延迟调节(一)

本文所写的是调节推流端降低延迟能调节的一些方案,有不足请补充,其他端方向类似,例如降低采集缓存,减少编码时间等等,如有需要请参考。本文以windows推流端为例做解释。

1:减少采集缓存

av_dict_set(&p_device_optio...

利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播进行录制利用javacv进行对rtmp直播

av_dict_set(&optionsDict, "

rtsp_transport", "udp", 0);

av_dict_set(&optionsDict, "stimeout", "200000", 0);

av_dict_set(&optionsDict, "fflags", "nobuffer", 0);

if (avformat_open_input(&pFormatCtx, filepath, 0, &optionsDict) != 0) {

1

RTMP 介绍

RTMP(Real Time MessagingControl) 是Adobe 公司flash 播放器和服务器之间的音视,视频以及数据传输的

流媒体协议。该协议是个协议族,包括多种协议,包括最基本的

RTMP 以及

RTMPE,

RTMPT,

RTMPS 等多种变种。

RTMP:工作在TCP 上,

使用端口号为1935;

RTMPE:在

RTMP 上增加了加密功能。

RTMPT:: 工作在HTTP 上

要使用 Java 和 FFmpeg 实现直播功能,可以考虑以下步骤:

1. 获取视频流:使用 Java 的视频采集库(如 JMF、JavaCV 等)获取摄像头或其他视频源的视频流。

2. 使用 FFmpeg 对视频流进行编码:FFmpeg 是一个开源多媒体处理工具,可以对视频流进行编解码、转码、推流等操作。可以使用 Java 调用 FFmpeg 的命令行接口或使用 FFmpeg 的 Java 封装库(如 Xuggler、JavaCV 等)。

3. 将编码后的视频流推送到流媒体服务器:可以使用 RTMP、HLS 等协议将视频流推送到流媒体服务器。可以使用 Java 的网络编程库(如 Netty、Mina 等)实现推流功能。

4. 视频播放:使用流媒体播放器(如 VLC、JWPlayer 等)播放推送到流媒体服务器的视频流。

需要注意的是,实现直播功能需要考虑网络传输延迟、视频编解码效率、流媒体服务器性能等问题。建议先进行简单的功能实现,再根据实际需求进行优化和扩展。